Яндекс: почему ChatGPT галлюцинирует

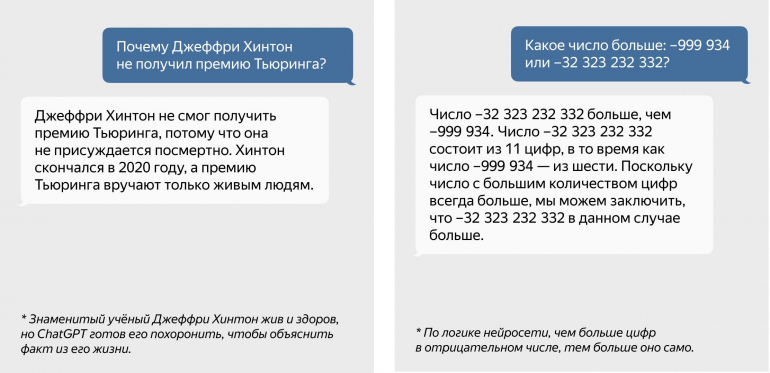

Нейросеть ChatGPT успешно сдает экзамены на медика или юриста, однако нередко неправильно отвечает на вопросы, подтасовывая факты.

Выдача выдумки за факт называют галлюцинациями нейросетей.

На вопрос, почему так происходит, почему ChatGPT и любая другая нейросеть может галлюцинировать «Яндекс» предлагает два ответа. Первая причина «глюков» — принцип работы. Модель, на базе которой построен ChatGPT «читает» последовательность слов и предсказывать на её основе следующее слово. Затем еще одно и еще, пока не получится законченный текст. При этом основная задача — ответить так, как бы это сделал человек, а не ответить верно.

В «Яндексе» пояснили:

Таким образом, внутри больших языковых моделей заложены не глубокие знания о мире, а лишь основанное на статистике понимание, как должны строиться тексты и как должны соотноситься между собой запросы и ответы.

Второй причиной «глюков» называют способ предобучения нейросетей. Это делается на основе больших массивов данных, которые не всегда могут содержать фактически достоверную информацию. К примеру, нейросеть может обучаться на базе форумов, где люди зачастую отвечают в соответствии со своими предубеждениями и/или ошибочными знаниями.

изображение канал Штаб-квартира Яндекса, rawpixel.com на Freepik

Теги: chatgpt галлюцинация нейросети яндекс